AMD是Nvidia的AI皇冠在很大程度上与新发起的本能处理器,它声称可以做多个gpu的工作。

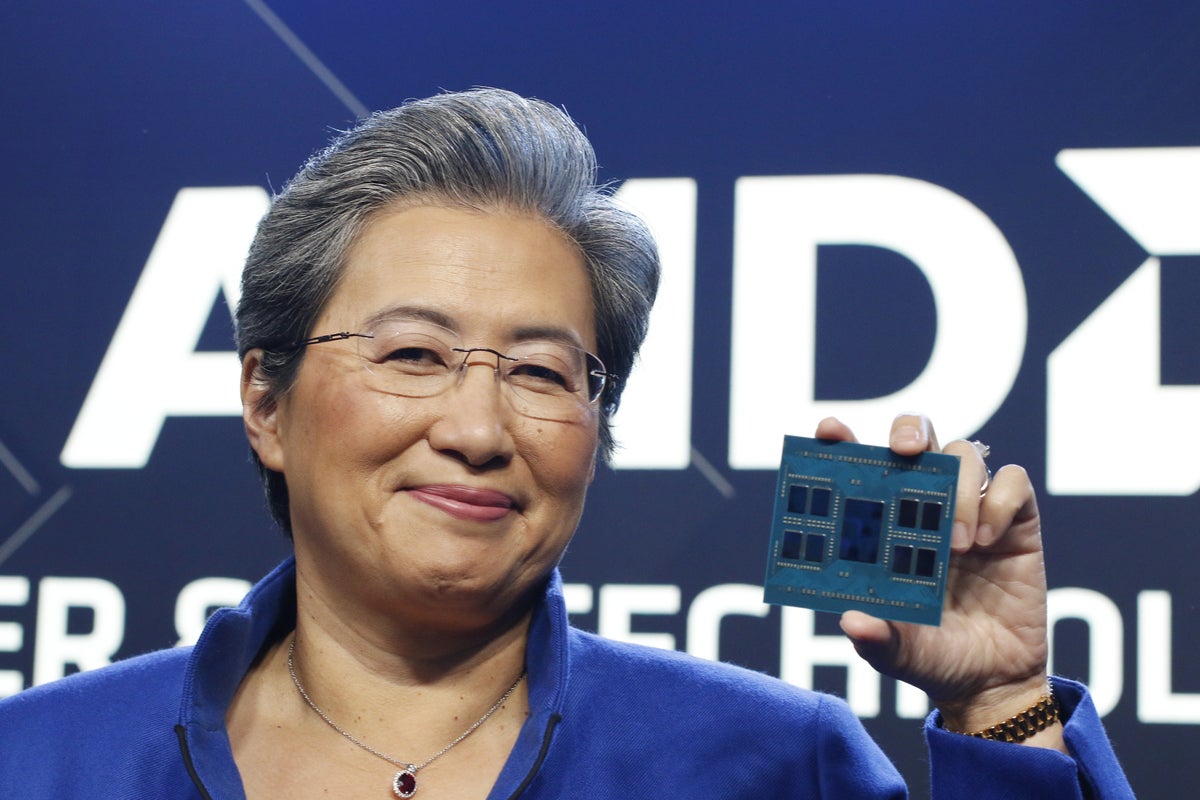

首席执行官丽莎苏本能MI300X称为“有史以来最复杂的事情我们。”她举起芯片大小的喝的过山车,在旧金山周二在一个事件。

重达1460亿个晶体管,MI300X高达192 gb的高带宽HBM3内存共享CPU和GPU。它共有13 chiplets死去。芯片也有5.2 TB的内存带宽/ s,比英伟达的H100快60%。

芯片由禅宗CPU核和AMD的下一代CDNA 3 GPU的体系结构。大量的内存是真正的卖点,据苏。

“如果你看今天的行业,你经常看到,首先,模型尺寸越来越大得多。实际上你需要多个gpu运行最新的大型语言模型,”她说。“MI300X,可以减少gpu,模型规模继续增长,这将变得更加重要。与更多的内存,因此需要更多的内存带宽,和更少的gpu。”

AMD说MI300X的设计使得它比现有MI250X使用更强大的八倍前沿(世界上最快的超级计算机)和更节能的5倍。它将用于两个exaFLOP埃尔卡皮坦系统,明年将建在劳伦斯利弗莫尔国家实验室。

作为声明的一部分,苏也公布了AMD本能平台,服务器参考设计基于规范的开放使用8 MI300X gpu的计算项目生成人工智能训练和推理工作负载。

这意味着企业和hyperscalers可以使用现有平台把MI300X gpu的本能(OCP服务器机架。

“我们实际上加速客户的整体上市时间,降低开发成本,使它很容易部署MI300X到他们现有的AI坡道和服务器建设,”苏说。

新的云CPU

在其他新闻,AMD讨论了其fourth-gen EPYC x4 97处理器代号为贝加莫。这个处理器是专门为云环境,它有许多虚拟机运行的核心。贝加莫有128芯超线程,所以配置系统可以有多达512个虚拟cpu。

苏谈论如何“出生在云中进行工作负载。“他们旨在充分利用新的云计算框架,他们本质上作为microservices运行。这些处理器的设计不同于通用计算——贝加莫处理器throughput-oriented不大,因此,许多核心设计。

“贝加莫利用所有平台的基础设施,我们已经开发了热那亚。和它支持相同的新生代记忆和输入输出功能。但是它让我们这个设计点扩大到128芯插座的领导在云中性能和能源效率,”苏说。

MI300X和贝加莫将抽样在第三季度开始。