麻省理工学院提出数字在一次会议上,初创公司Nervana宣布了为神经网络和机器学习应用程序设计和制造专用ASIC处理器的计划,该公司首席执行官Naveen Rao称,该处理器的运行速度将比图形处理器(GPU)快10倍。

在此之前,谷歌上周宣布,他们已经秘密部署了自己的神经网络machine-learning-tailored处理器大约一年前在它2020欧洲杯预赛的数据中心。该公司报告称,其定制处理器的性能提高了一个数量级。谷歌的方法和性能改进验证了Nervana的技术策略。

+更多关于网络世界:足球竞猜app软件掌握机器学习的13个框架+

gpu已经成为机器学习的同义词。几年前,多伦多大学人工智能(AI)杰出学生Geoff Hinton的学生Alex Krizhevsky证明了机器学习系统可以在价格低廉的GPU硬件上进行训练,人们对机器学习的兴趣爆发了。Krizevsky在意识到GPU可以用于加速神经网络向量数学计算后,编写了一个大规模并行GPU板来解决深度学习问题。Rao说,gpu在超大规模移动市场的应用使得这些处理器便宜而有效,但并没有优化机器学习。

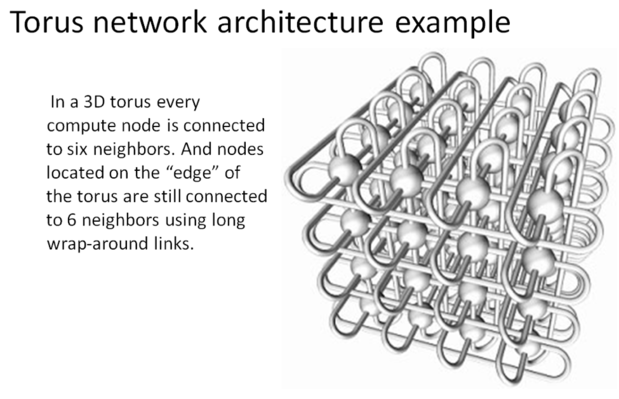

Nervana的定制专用集成电路称为Nervana引擎,每个处理器模块都有32GB的内存。在处理模块内,片上存储存储器互连传输速率为8Tbps。处理器模块以类似超级计算机的环面配置互连,可以以2.4Tbps的速度将数据内存传输到内存。

富士通和理研,2009年

富士通和理研,2009年

Rao说,机器学习系统的训练速度要快10倍,因为更大的数据模型可以加载到内存中并并行处理。饶在解释Nervana引擎的结构时引用了Antoine de Saint-Exupery的话,“当没有什么要添加的时候,完美就达到了,当没有什么要移除的时候。”指令集被简化为一组为机器学习而优化的原语集,这与RISC处理器使用更少指令设计的方式非常相似。因为神经网络程序规定操作和内存访问,在gpu中使用的托管内存缓存层次被消除,加速执行和打开更多的die空间。

Nervana发动机将由台积电制造,设备尺寸为28nm,预计2017年初交付。饶说,随后缩小到16nm的设备尺寸可以使性能翻倍。

Neon为Nervana工程师提供了更多的控制,更高的性能

Nervana开发了自己的基于python的机器学习库Neon,它针对神经网络应用进行了优化,比如机器翻译、图像分类、目标定位、文本分析和视频索引。Neon目前运行在运行专有微码的Nvidia gpu上。通过对应用层和微码层的工程控制,Nervana的工程师优化了执行时间。当Nervana引擎发布后,它将能够优化所有三层:应用程序、微码和硬件。

Nervana发表了Neon在Nvidia gpu上运行的基准测试——由Facebook研究员苏米特·钦塔拉(Soumith chintal)撰写。Rao说,当Nervana引擎交付基准测试时,性能将得到一个数量级的提高。

Nervana为包括孟山都在内的客户提供运行在Nvidia gpu上的Neon云服务。这些工作负载将在2017年转移到Nervana引擎上。

机器学习的最后一英里

机器学习专家和程序员的数量无法接近企业用机器学习解决高价值问题所需的数量。《经济学人》最近发表了一篇文章报道人工智能专家的竞争在硅谷知名公司和学术界之间。在技术人才的竞争中,企业是备受追捧的专家的遥远的第三选择。

Nervana为企业IT部门、数据科学家和统计学家提供专业服务,为机器学习提供了最后一公里。